Google pokazał asystenta AI jak z filmu. Project Astra to odpowiedź na GPT-4o

Dzieje się w świecie sztucznej inteligencji, oj, dzieje. Jeszcze nie zdążyliśmy zebrać szczęk z podłogi po prezentacji OpenAI, a Google już odpowiada na ruch swojego rywala.

Firma OpenAI dopiero co zaprezentowala nowy multimodalny model GPT-4o, dzięki któremu ChatGPT będzie w stanie w czasie rzeczywistym odpowiadać na pytania na temat tego, co widzi kamera smartfonu lub wyświetlane jest na ekranie komputera. Chyba wyjaśniło się, dlaczego startup zorganizował swoją konkferencję w przeddzień Google I/O 2024. Najwidoczniej firma była świadoma, że Google pracuje nad czymś bardzo podobnym.

Oto Project Astra. Google chce, byś poczuł się jak w filmie sci-fi

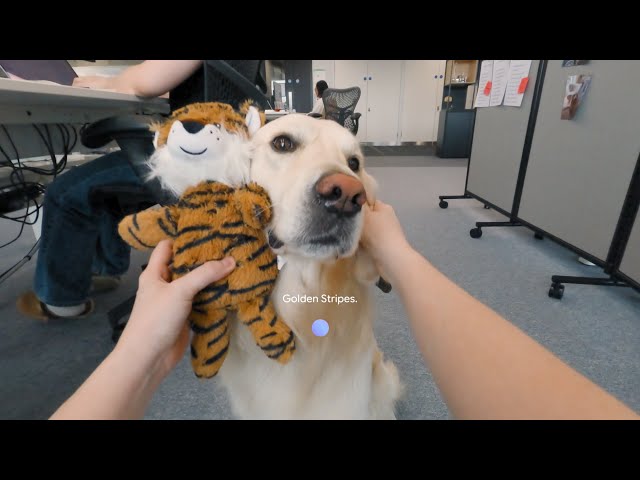

Project Astra to prototyp multimodalnego dużego modelu językowego, który łączy analizę obrazu, dźwięku i tekstu. Na demonstracji widzimy kobietę, która spaceruje po biurze z włączonym aparatem telefonu i zadaje złożone pytania na temat otoczenia. Wirtualny asystent bez zająknięcia rozwiewa wątpiwości związane z powstającym kodem, pomaga usprawnić schemat firmowej serwerowni, proponuje nazwę dla psiego zespołu czy wskazuje zgubione okulary.

No właśnie - okulary. W pewnym momencie kobieta przełącza się na kamerę zamontowaną w nich i kontynuuje konwersację ze sztuczną inteligencją. Czyżby nadchodził następca Google Glass?

Google nie ukrywa, że asystent i okulary znajdują się jeszcze w fazie prototypowania, ale niektóre z zaprezentowanych możliwości mają zostać zintegrowane z aplikacją Gemini i "innymi produktami" firmy jeszcze w tym roku. Zanosi się jednak na to, że - mimo zbliżonego terminu prezentacji - Project Astra zaliczy swój rynkowy debiut znacznie później niż głosowo-obrazowy asystent OpenAI, który ma trafić do użytkowników w ciągu kilku tygodni.

Komentarze

5